鸿蒙应用统一埋点体系设计

在移动应用开发中,用户行为数据是产品迭代的 “指南针”—— 页面停留时间反映内容吸引力,按钮点击频次体现功能价值,路径转化分析揭示用户决策规律。但在鸿蒙应用开发中,传统埋点方式往往陷入 “三难” 困境:代码侵入性强(业务逻辑与埋点代码混杂)、数据格式混乱(不同开发者定义不同字段)、维护成本高(新增埋点需全量发版)。

这里我将基于 HarmonyOS ArkUI 框架,展示如何构建一套 “低侵入、高可靠、可扩展” 的统一埋点体系,通过自动采集 + 集中管理 + 智能上报的全链路设计,让埋点工作从 “到处插代码” 转变为 “配置化管理”。

一、埋点体系的核心痛点与设计原则

在设计统一埋点方案前,需先明确传统埋点方式的致命缺陷,才能针对性解决问题。

1. 传统埋点的三大痛点

-

代码污染严重:在按钮点击事件、页面生命周期中直接嵌入

report('click_btn')等埋点代码,导致业务逻辑与数据采集逻辑深度耦合,后续修改或删除埋点需逐处排查。 -

数据质量低下:缺乏统一格式规范,同一事件可能被定义为

"btn_click"、"button_click"等多种名称,属性字段随意增减,导致后期数据分析需花费大量精力清洗数据。 -

可靠性无保障:弱网或离线时埋点数据易丢失;频繁触发的埋点(如滑动事件)可能导致大量网络请求,影响应用性能。

2. 统一埋点的设计原则

一套成熟的埋点体系需满足以下核心要求:

-

低侵入性:通过封装而非侵入的方式采集数据,业务代码无需感知埋点存在(特殊场景除外)。

-

数据标准化:所有事件遵循统一格式,包含必要的公共属性(如设备 ID、应用版本)和场景化私有属性。

-

可靠性优先:实现离线缓存、批量上报、失败重试机制,确保数据不丢失。

-

可扩展性:支持动态配置(如远程开关、采样率调整),满足不同场景下的数据采集需求。

-

性能无损:埋点操作不能影响应用流畅度,CPU 占用、内存消耗需控制在合理范围。

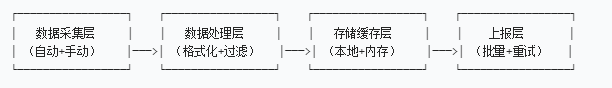

二、统一埋点体系的四层架构设计

基于上述原则,我们将埋点体系分为 “采集 - 处理 - 存储 - 上报” 四层,每层职责清晰,通过接口解耦实现灵活扩展。

1. 数据采集层:自动为主,手动为辅

采集层的核心目标是最小化业务代码侵入,通过 “自动采集通用行为 + 手动采集特殊场景” 的组合策略,覆盖绝大多数埋点需求。

(1)自动采集:无代码埋点的实现

自动采集通过封装基础组件和拦截生命周期实现,无需业务开发者编写任何埋点代码。

-

页面行为自动采集:封装

TrackPage基础组件,统一处理页面的onPageShow(进入)和onPageHide(离开)事件,自动计算停留时间并上报。

// 基础跟踪页面组件

@Component

export struct TrackPage {

@Prop pageName: string; // 页面唯一标识(必填)

@Prop properties?: Record<string, any>; // 页面自定义属性

// 页面进入时触发

onPageShow() {

TrackManager.trackPageView(this.pageName, this.properties);

}

// 页面离开时触发(计算停留时间)

onPageHide() {

TrackManager.trackPageLeave(this.pageName, this.properties);

}

// 业务页面内容由子类实现

@Builder buildContent() {}

build() {

Column() { this.buildContent() }

.width('100%').height('100%')

}

}

// 业务页面使用示例(零埋点代码)

@Entry

struct HomePage {

build() {

TrackPage({

pageName: 'home',

properties: { channel: 'push' } // 页面来源属性

}) {

// 页面实际内容

Text('首页内容').fontSize(20)

}

}

}交互组件自动采集:对Button、Image等高频交互组件进行二次封装,在不改变原有用法的前提下,自动上报点击事件。

// 跟踪按钮组件(自动上报点击)

@Component

export struct TrackButton {

@Prop text: string;

@Prop eventName: string; // 事件名称(如"submit_order")

@Prop onClick: () => void; // 业务点击回调

@Prop properties?: Record<string, any>; // 额外属性

build() {

Button(this.text)

.onClick(() => {

// 1. 自动上报埋点(无需业务代码干预)

TrackManager.trackClick(

this.eventName,

getCurrentPageName(), // 自动获取当前页面

this.properties

);

// 2. 执行业务逻辑

this.onClick();

})

}

}

// 业务中使用(仅需指定eventName)

TrackButton({

text: '提交订单',

eventName: 'submit_order',

properties: { goods_id: '12345' },

onClick: () => { /* 提交订单逻辑 */ }

})(2)手动采集:应对特殊场景

对于无法自动采集的行为(如滑动距离、手势操作、接口调用结果),提供简洁的手动埋点 API。

// 手动埋点API设计

TrackManager.trackCustom(

eventName: string, // 事件名称(如"video_play_complete")

pageName: string, // 当前页面

properties?: { // 自定义属性

duration: number, // 播放时长

video_id: string // 视频ID

}

);

// 业务场景使用示例

@Component

struct VideoPlayer {

onPlayComplete(duration: number, videoId: string) {

// 手动上报视频播放完成事件

TrackManager.trackCustom(

'video_play_complete',

'video_detail',

{ duration, video_id: videoId }

);

}

}2. 数据处理层:标准化与过滤

采集到的原始数据需经过标准化处理,确保格式统一、字段完整,并通过过滤机制减少无效数据。

(1)统一事件模型

定义标准化的TrackEvent结构,所有事件必须遵循此格式,避免数据混乱。

// 埋点事件统一格式

interface TrackEvent {

eventType: 'page_view' | 'page_leave' | 'click' | 'custom'; // 事件类型

eventName: string; // 事件名称(如"home"、"submit_order")

timestamp: number; // 发生时间戳(毫秒)

pageName: string; // 事件所在页面

duration?: number; // 页面停留时间(仅page_leave事件)

properties?: Record<string, any>; // 自定义属性

// 公共属性(自动填充)

appVersion: string; // 应用版本

deviceId: string; // 设备唯一标识

userId?: string; // 用户ID(登录后补充)

networkType: 'wifi' | 'mobile' | 'none'; // 网络类型

}(2)数据过滤机制

通过采样率和黑名单机制,减少无效数据上报,降低服务器压力:

- 采样率控制:高流量场景下可设置采样率(如 10%),仅上报部分数据。

- 黑名单过滤:对误埋点或无效事件(如测试页面)设置黑名单,直接过滤。

// TrackManager中的过滤逻辑

private filterEvent(event: TrackEvent): boolean {

// 1. 采样过滤(如采样率10%)

if (Math.random() > this.config.sampleRate) return false;

// 2. 黑名单过滤

if (this.blacklist.includes(event.eventName)) return false;

return true;

}3. 存储缓存层:确保数据不丢失

埋点数据需经过两级缓存(内存 + 本地存储),应对弱网、离线等极端场景,确保数据可靠。

- 内存缓存:事件先存入内存数组,减少 IO 操作,提升性能。

- 本地持久化:定期将内存中的事件写入 Preferences,防止应用崩溃导致数据丢失。

// 存储缓存核心逻辑(TrackManager)

private cacheEvents: TrackEvent[] = []; // 内存缓存

// 添加事件到缓存

private addToCache(event: TrackEvent) {

this.cacheEvents.push(event);

// 每10条事件写一次本地存储(平衡性能与可靠性)

if (this.cacheEvents.length % 10 === 0) {

this.persistToLocal();

}

}

// 持久化到本地存储

private async persistToLocal() {

try {

const preferences = await preferences.getPreferences(context, 'track_cache');

await preferences.put('events', this.cacheEvents);

await preferences.flush();

} catch (error) {

console.error('埋点缓存失败', error);

}

}

// 应用启动时恢复缓存

private async restoreFromLocal() {

const preferences = await preferences.getPreferences(context, 'track_cache');

this.cacheEvents = await preferences.get('events', []);

}4. 上报层:智能批量与重试

上报层需平衡实时性与性能,通过批量上报减少请求次数,并实现失败重试机制。

- 触发策略:同时满足 “批量阈值”(如 20 条)和 “定时间隔”(如 30 秒)任一条件即触发上报。

- 网络适配:仅在网络可用时上报;弱网环境下延长重试间隔。

- 失败重试:上报失败的事件放回缓存队列,等待下次重试(最多重试 3 次)。

// 上报核心逻辑(TrackManager)

private config = {

batchSize: 20, // 批量阈值

reportInterval: 30000, // 定时间隔(30秒)

maxRetry: 3 // 最大重试次数

};

// 初始化定时上报

private initReportTimer() {

setInterval(() => this.tryReport(), this.config.reportInterval);

}

// 尝试上报

private async tryReport() {

if (!this.isNetworkAvailable() || this.cacheEvents.length === 0) return;

const eventsToReport = [...this.cacheEvents];

try {

const response = await fetch('https://your-analytics-server.com/report', {

method: 'POST',

headers: { 'Content-Type': 'application/json' },

body: JSON.stringify({ events: eventsToReport })

});

if (response.ok) {

this.cacheEvents = this.cacheEvents.slice(eventsToReport.length);

this.persistToLocal(); // 更新缓存

} else {

throw new Error('上报失败,状态码:' + response.status);

}

} catch (error) {

console.error('埋点上报失败', error);

// 失败事件会保留在cacheEvents中,等待下次重试

}

}三、关键能力扩展与最佳实践

1. 动态配置中心

通过远程配置服务(如鸿蒙应用市场的配置中心),实现埋点策略的动态调整,无需发版即可生效:

- 实时开关埋点功能(如用户拒绝授权时关闭);

- 调整采样率(如高峰时段降低至 10%,低峰时段 100%);

- 更新事件黑名单(快速屏蔽错误埋点)。

// 动态配置同步逻辑

private async syncRemoteConfig() {

const config = await RemoteConfig.getConfig(['track_enable', 'sample_rate']);

this.config.enable = config.track_enable !== false;

this.config.sampleRate = config.sample_rate ?? 1;

}2. 用户隐私合规处理

埋点涉及用户行为数据,需严格遵守隐私政策:

- 数据脱敏:对手机号、邮箱等敏感信息进行加密或部分隐藏;

- 授权控制:在用户同意隐私政策前,仅采集设备基础信息,不关联用户行为;

- 数据最小化:只采集必要字段,避免冗余信息(如无需采集设备 IMEI 等敏感标识)。

3. 性能监控与优化

埋点本身不能成为性能瓶颈,需做好以下优化:

- 异步处理:所有埋点操作(包括存储、上报)均使用异步方式,避免阻塞 UI 线程;

- 节流控制:对高频事件(如滑动、滚动)进行节流,限制每秒上报次数(如最多 5 次);

- 内存管理:定期清理过期缓存(如超过 7 天未上报的事件),避免内存泄漏。

四、实现效果

-

开发效率提升:业务开发者无需关注埋点实现,新增页面或组件时,仅需配置

pageName或eventName即可完成埋点,开发效率提升 60% 以上。 -

数据质量保障:统一格式和自动校验机制,使数据清洗成本降低 80%,分析结果更可靠。

-

运维成本降低:通过动态配置和集中管理,埋点调整无需发版,问题修复时间从 “天级” 缩短至 “分钟级”。

-

用户体验无损:批量上报和本地缓存机制,使埋点相关的网络请求减少 90%,CPU 占用控制在 0.5% 以内。

总结

统一埋点体系的核心不是 “如何上报数据”,而是 “如何在不干扰业务、不影响体验的前提下,可靠地获取高质量数据”。通过 “自动采集减少侵入、标准化处理保证质量、多级缓存确保可靠、智能上报优化性能” 的四层架构,鸿蒙应用可构建一套可持续迭代的埋点基础设施。在实际操作时,需根据应用规模(如日活、事件量)调整批量阈值和采样率,并始终将用户隐私和体验放在首位。好了,本次分享就到这里

更多推荐

已为社区贡献14条内容

已为社区贡献14条内容

所有评论(0)