Google 的 AI 开发技术栈学习路径

Google发布AI开发全栈工具,引领技术创新。其Gemini模型家族涵盖多模态、长上下文窗口和高推理能力,适用于编码、医疗等领域。Gemma 3支持多语言和多模态,医疗专用版MedGemma可辅助诊断。开发工具Google AI Studio和Gemini API简化AI应用构建。框架层提供Keras微调、JAX大规模计算及Tunix优化模型。基础设施XLA加速器优化和LLM-d项目提升分布式服

前言

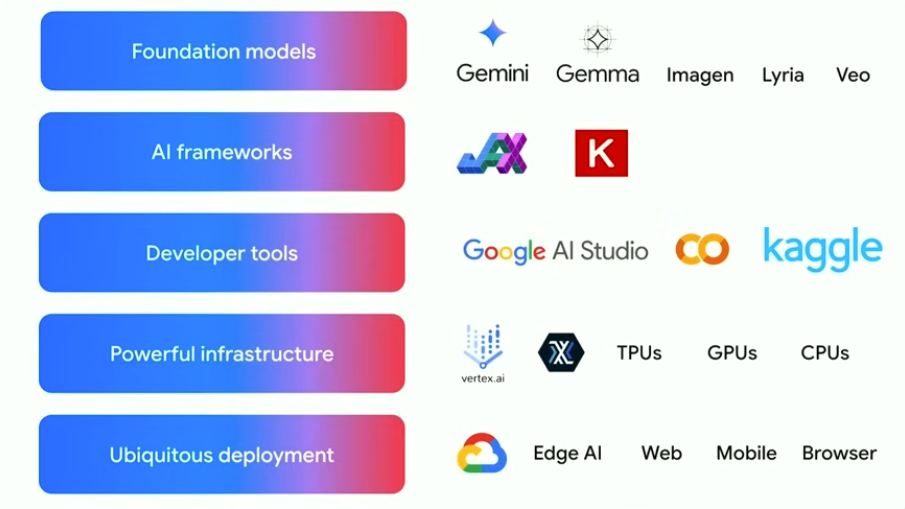

Google 在 AI 领域拥有悠久的领先历史,自 2015 年开源 TensorFlow 以及 2017 年发表关于变换器的开创性研究以来,如今已进入 Gemini 时代。Google 致力于通过强大且灵活的 AI 堆栈,将最先进的模型和工具提供给开发者,以构建能够改变各个领域的实际应用程序。

基础模型

-

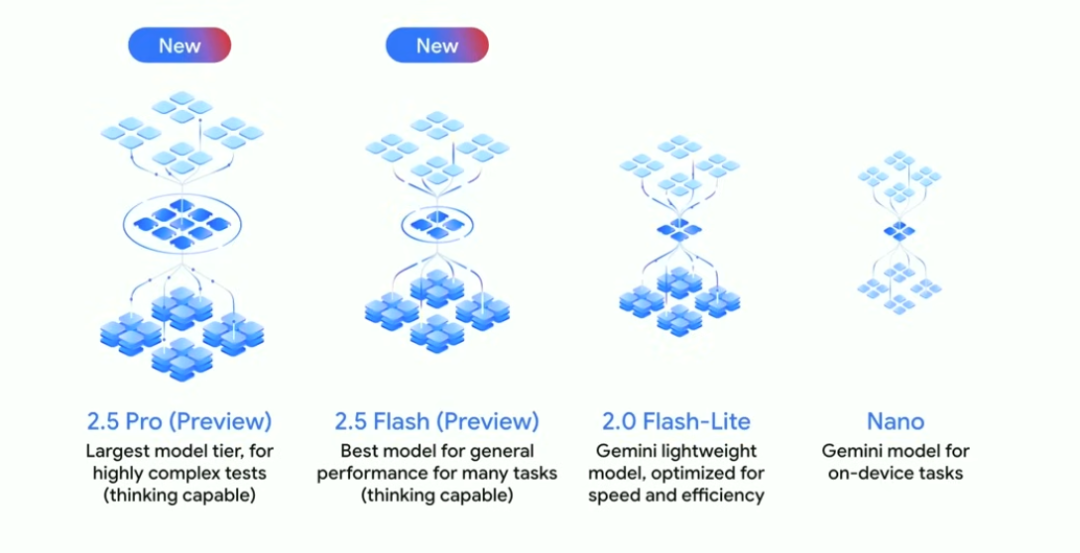

Gemini 模型家族:是 Google 最强大和通用的模型家族,以多模态、长上下文窗口和强大的推理能力著称。针对不同的用例,Gemini 有多种型号。例如,Gemini 2.5 Pro 擅长深度推理的高复杂任务,在编码方面表现出色,不仅能根据自然语言描述生成高质量代码,还能理解和修复现有代码逻辑错误,领先于 WebDev Arena 等编码基准测试;Gemini 2.5 Flash 效率高、速度快,在各方面基准测试中都有提升,尤其适合实时对话系统等需要快速响应的场景;Gemini 2.0 Flash 快速且成本低;Gemini Nano 则针对设备端任务进行了优化,轻量级的特点使其适合在移动设备和边缘设备上运行,为本地应用提供智能支持。

-

Gemma 模型:今年早些时候发布的 Gemma 3 是 Google 最先进的模型,有 1B、4B、12B 和 27B 四种尺寸,为开发者提供了优化不同应用程序性能的灵活性。其中,4B、12B 和 27B 模型是多模态、多语言的,上下文窗口长达 128,000 个令牌,并且支持 140 多种语言,这使其能够服务全球范围内的用户,特别是在那些非英语为主要语言的地区。此外,还有针对医疗领域的 MedGemma,可帮助医生分析医学图像、理解病历文本,辅助诊断决策,以及为设备端操作优化的 Gemma 3n 等多种变体。

开发工具与平台

-

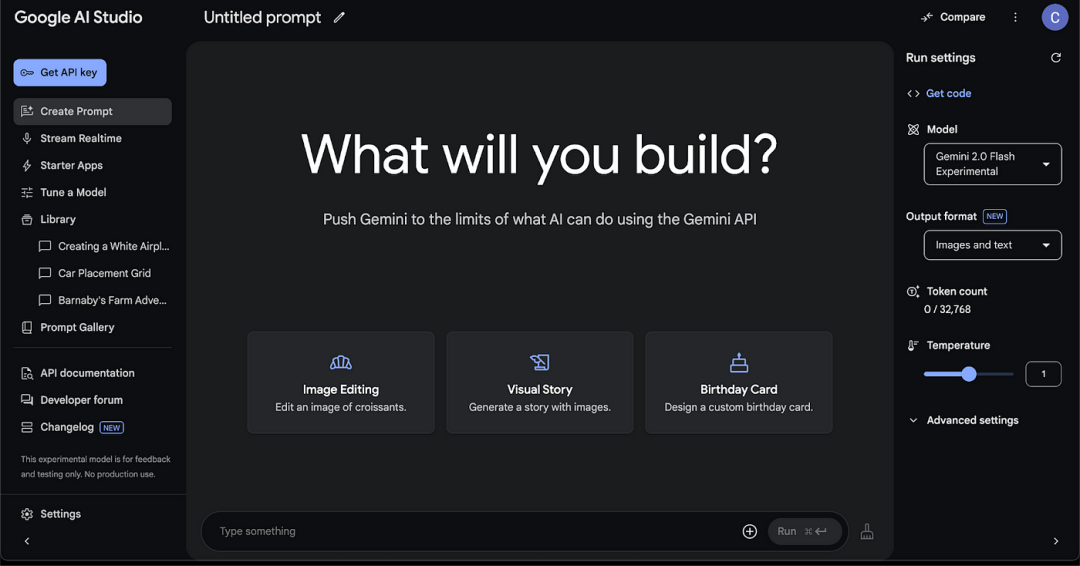

Google AI Studio:是开发者开始使用 AI 的理想场所,无需了解 Google Cloud 知识,免费使用。在这里可以创建、测试和保存提示,还有入门应用程序提供灵感。其具有一些新功能,如 “构建” 选项卡可通过自然语言即时生成 Web 应用程序,通过简单的拖放操作和自然语言描述,开发者即可创建复杂的 AI 应用;还有新的生成式媒体体验,支持原生音频和文本到语音转换等,为创意工作者提供了强大的工具。

-

Gemini API:提供了简单易用的开发方式,具备代码执行、函数调用等功能,还支持图像和视频理解与生成。此外,还有一些新功能,如文本到语音的新功能可控制情感和风格,为语音助手和有声读物等应用带来更加生动和个性化的体验;增强的工具允许将 Google 搜索、代码执行和 URL 上下文等功能在一个 API 调用中结合使用,并且提供了 Gemini SDK 对 MCP 的支持,简化了构建代理功能的过程。

开发框架

-

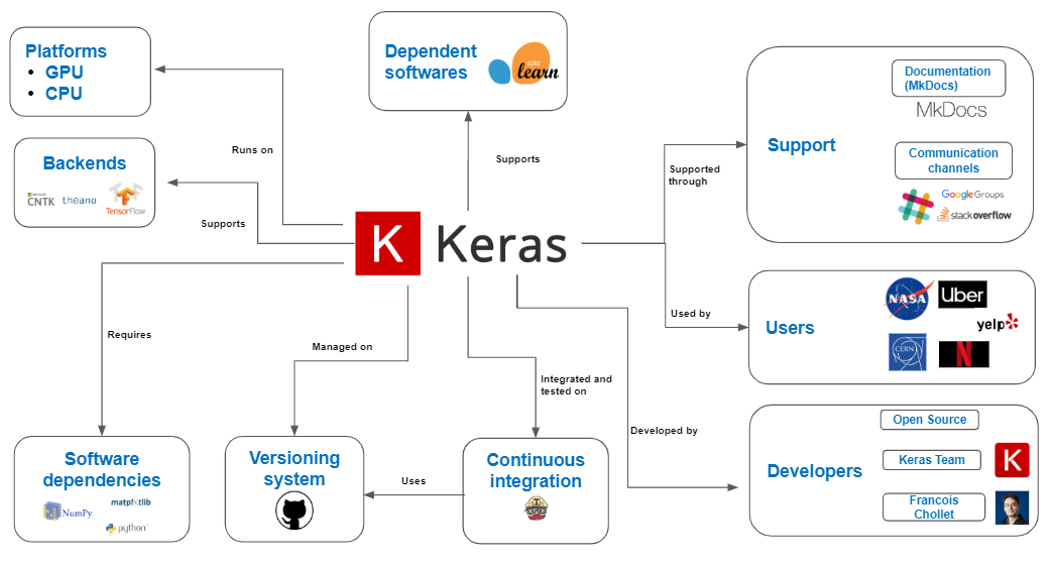

Keras: 使用 Keras 进行模型微调非常简单,只需一个包含提示和响应的两列 CSV 文件,通过几行代码就可以对模型进行训练,以适应特定的任务和数据。在医疗领域,Keras 可用于训练模型来识别医学图像中的病变,如 X 光片和 MRI 图像,通过微调预训练的模型,开发者可以快速获得高性能的医疗 AI 应用。

-

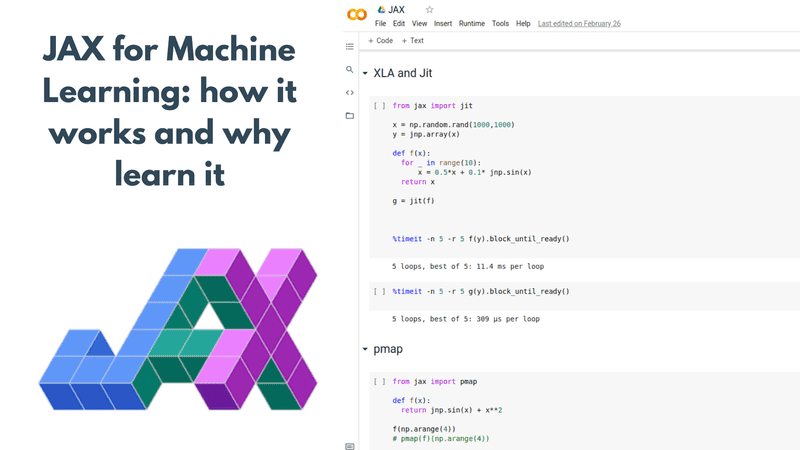

JAX:

是用于研究的出色 Python 机器学习库,在大规模计算方面表现出色,可轻松扩展到数万个加速器,Google 用它来构建 Gemini 和 Gemma 模型,社区也用它来构建大型基础模型。JAX 核心具有 NumPy API,方便开发者在理解新模型或新技术时,以 NumPy 代码逐行实现和调试,然后通过简单添加代码进行梯度计算和模型编译,就可以在 GPU 和 TPU 上运行,而无需更改其他代码。此外,还有 MaxText 和 MaxDiffusion 等基于 JAX 的 GitHub 库,分别提供了大型语言模型和图像生成模型的参考实现,为研究人员提供了开发起点。

-

Tunix: 是一个正在开发中的新库,旨在为开发者提供易于使用的工具,同时为研究人员提供在 JAX 中实现最新后训练算法的良好框架,目前正在与社区合作开发中。后训练算法在优化模型性能和减少模型大小方面起着重要作用,通过 Tunix,开发者可更轻松地应用这些算法,提高模型的效率和性能。

基础设施

-

XLA:是一个机器学习编译器,用于将 Python 代码编译和优化,以便在 GPU 和 TPU 等加速器上运行。它是 Google 整个生产堆栈的核心,被全球一些最大的大型语言模型构建者使用。XLA 具有可移植性,不仅可以在 TPU 上运行,还可以在 GPU 和其他类型的加速器上运行。现在 PyTorch 也可以与 XLA 配合使用,开发者可以使用 PyTorch XLA 在 TPU 上训练模型,并获得良好的性价比优势。在训练大型语言模型时,XLA 可将多个计算操作融合在一起,减少内存访问和提高计算效率。

-

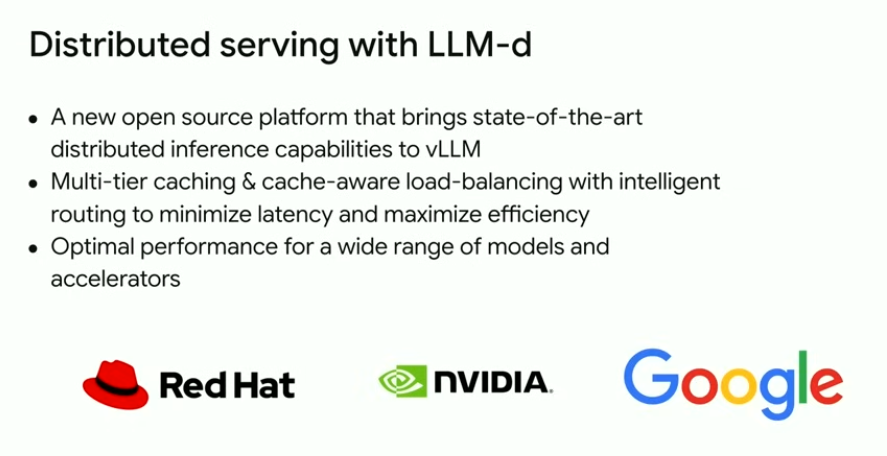

LLM - d 项目:是 Red Hat、NVIDIA 和 Google 之间的新合作项目,旨在将分布式服务的最佳实践引入开源领域,使其适用于 JAX 和 PyTorch,为开发者提供更好的服务解决方案。该项目通过整合三方技术优势,提供了一个高效、可扩展的分布式服务框架,帮助开发者更轻松地部署和服务大型语言模型。

边缘计算

- Google AI Edge 是用于在 Android、iOS、浏览器和嵌入式设备上部署机器学习模型的框架。将模型部署在移动设备上有诸多好处,如降低延迟,对于手势识别等应用,本地运行模型可避免因云服务器传输导致的帧丢失;保护隐私,数据无需离开设备;节省成本,减少了在云端为大量用户提供服务的计算成本。Google AI Edge 支持最新的 Gemma 模型,与 Hugging Face 社区合作,有很多预优化的模型可供在设备上运行,并且即将推出 AI Edge Portal 私人预览版,这是一个测试服务,可在不同尺寸的真实设备上验证模型的运行效果。在智能相机和可穿戴设备等应用中,Google AI Edge 已取得成功。

未来展望

- AlphaEvolve:是一个由 Gemini 驱动的编码代理,用于设计高级算法,是一个自我改进的编码代理,旨在扩展大型语言模型在数学和编码方面解决基本和高度复杂问题的能力。它可帮助开发者自动生成复杂算法,甚至发现新算法和优化现有算法,在密码学等领域有潜在应用。

- AI co - scientist:是医学和研究领域的科学突破,旨在加速科学发现和药物开发。科学家可以用自然语言向代理给出研究目标,然后 AI co - scientist 会通过一组协同工作的代理,给出研究概述、假设和方法。在药物开发和癌症研究等领域,AI co - scientist 可发挥重要作用。

- Gemini 机器人模型:目前处于私人早期访问阶段,是先进的视觉、语言和行动模型,将物理行动作为新的输出模态,用于控制机器人。这些模型与机器人无关,可用于从人形机器人到大型工业机械的各种设备,并且经过微调具有灵巧性,可实现折叠折纸、拿三明治袋等多种应用,推动机器人技术在工业和服务领域的发展。

Google 的 AI 开发堆栈为开发者提供了全面而强大的工具和技术,从基础模型到开发框架,从基础设施到边缘计算,再到未来的创新方向,都展现了 Google 在 AI 领域的领先地位和强大实力。开发者可以利用这些资源,构建出更加智能、高效和创新的应用程序,推动 AI 技术在各个领域的广泛应用和发展。

更多推荐

已为社区贡献17条内容

已为社区贡献17条内容

所有评论(0)