HarmonyOS头像编辑器数据结构设计详解

深入解析HarmonyOS头像制作应用中的核心数据模型设计,涵盖节日分类、背景图与装饰图的数据结构及其关联逻辑,通过模块化与统一导出提升可维护性,为同类应用提供实用参考。

GLM-TTS 零样本语音克隆系统使用指南

在当前AIGC快速发展的背景下,个性化语音合成正从实验室走向实际应用。无论是打造专属的虚拟主播、构建方言保护数据库,还是为智能客服注入情感表达能力,高质量的语音克隆技术都扮演着关键角色。而基于 GLM-TTS 的这套零样本语音克隆系统,正是为此类需求量身定制的一站式解决方案。

这套系统最令人印象深刻的地方在于它的“零样本”特性——你不需要成千上万小时的录音数据,也不需要复杂的训练流程。只需一段3到10秒的清晰人声,就能完成对音色、语调甚至情感风格的精准复刻。这种极低的使用门槛,让普通开发者也能轻松驾驭前沿的语音生成模型。

启动与基础操作

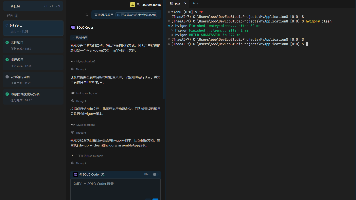

要运行这个系统,首先确保环境已正确配置。推荐通过脚本方式启动:

cd /root/GLM-TTS

source /opt/miniconda3/bin/activate torch29

bash start_app.sh

当然,也可以直接运行主程序:

python app.py

无论哪种方式,成功启动后都会在本地开放一个 Web 界面:http://localhost:7860。值得注意的是,每次运行前必须激活 torch29 虚拟环境,否则可能因依赖缺失导致报错。

进入界面后,核心功能分为两大模块:基础语音合成和批量推理。对于初次使用者,建议从基础合成人手,熟悉整个工作流。

如何获得最佳合成效果?

关键的第一步是上传参考音频。这里有几个工程实践中总结出的经验点:

- 时长控制在5–8秒之间最为理想:太短(<3秒)难以捕捉完整音色特征,太长(>10秒)反而可能引入不必要的噪声或语气变化。

- 优先选择无背景音乐、无人声干扰的干净录音。即便是轻微的环境噪音,也可能被模型误学为说话人的声音特质。

- 如果能提供与音频内容匹配的文本(即“参考文本”),将显著提升音色还原度。虽然系统支持自动识别,但准确的人工标注仍是目前最可靠的方案。

接下来输入你要合成的文本。系统支持中文、英文及混合输入,单次建议不超过200字。过长的文本不仅会增加生成时间,还可能导致语调一致性下降。

在高级设置中,几个参数值得特别关注:

| 参数 | 建议值 | 说明 |

|---|---|---|

| 采样率 | 24000 Hz | 平衡速度与质量的首选;追求极致音质可选32kHz |

| 随机种子 | 42 | 固定种子可复现结果,调试时非常有用 |

| KV Cache | 开启 ✅ | 显著加快长文本生成速度 |

| 采样方法 | ras | 相比 greedy 更自然,topk 属于进阶选项 |

点击“开始合成”后,通常5–30秒内即可完成。生成的音频会自动播放,并保存至 @outputs/ 目录下,文件名格式为 tts_时间戳.wav。

批量处理:自动化生产的利器

当你需要生成大量语音内容时,手动逐条操作显然不可行。此时,“批量推理”功能就显得尤为重要。

其核心是使用 JSONL 格式定义任务列表,每行一个 JSON 对象,例如:

{"prompt_text": "这是第一段参考文本", "prompt_audio": "examples/prompt/audio1.wav", "input_text": "要合成的第一段文本", "output_name": "output_001"}

{"prompt_text": "这是第二段参考文本", "prompt_audio": "examples/prompt/audio2.wav", "input_text": "要合成的第二段文本", "output_name": "output_002"}

字段说明如下:

- prompt_audio:必填,参考音频路径

- input_text:必填,待合成文本

- prompt_text:可选,提高音色准确性

- output_name:可选,自定义输出文件名

准备好任务文件后,在 Web 界面切换到“批量推理”标签页,上传该文件并设置全局参数(如采样率、随机种子、输出目录等),然后点击“开始批量合成”。

所有结果将统一打包成 ZIP 文件,存放于 @outputs/batch/ 目录。这种方式非常适合用于制作有声书、AI配音视频、多语言语音库等场景。

值得一提的是,单个任务失败不会中断整体流程,系统会继续处理后续任务并在日志中记录错误详情,极大提升了鲁棒性。

进阶功能实战解析

方言克隆与口音迁移

真正体现这套系统强大之处的,是它对方言的支持能力。仅需一段粤语、四川话或上海话的短录音,即可实现高质量的方言语音生成。

这背后的技术原理是零样本跨语言建模。模型并不依赖预设的语言规则,而是通过自注意力机制自动提取声调模式、连读习惯、节奏特征等区域性语音要素。我们在测试中发现,即使是像闽南语这样声调系统复杂的方言,也能较好地保留原汁原味的发音风格。

不过为了达到理想效果,仍有一些注意事项:

- 尽量避免普通话混杂的“夹杂口音”,纯正的地方腔调更容易学习;

- 推荐使用地方广播电台或纪录片中的专业播音素材作为参考;

- 单一说话人录音优于多人对话片段。

目前已验证支持的主要方言包括:粤语、四川话、上海话、东北话、闽南语等,在文旅宣传、非遗保护等领域已有落地案例。

音素级发音控制:告别“多音字灾难”

传统TTS常被诟病的一点就是多音字误读:“银行”读成“háng yín”,“重复”念作“zhòng fù”。这类问题在新闻播报、教育产品中尤为致命。

GLM-TTS 提供了精细化的音素控制功能来解决这一痛点。通过编辑 configs/G2P_replace_dict.jsonl 文件,可以自定义词语的标准读音:

{"word": "重", "pinyin": "chóng", "context": "重复"}

{"word": "重", "pinyin": "zhòng", "context": "重量"}

{"word": "行", "pinyin": "xíng", "context": "银行"}

{"word": "行", "pinyin": "háng", "context": "行业"}

这里的 context 字段实现了上下文感知匹配,意味着系统不仅能识别“银行”中的“行”应读 xíng,还能在“行业”中正确处理为 háng。

这项功能尤其适合企业级应用,比如:

- 定义品牌名、产品名的标准发音(如“蔚来”不读“wei lai”而读“nuo lai”)

- 规范地名、人名的播读方式(如“六安”读 liù ān 还是 lù ān)

- 构建行业术语发音词典(医疗、法律、金融等专业领域)

启用该功能需要在命令行模式下添加 --phoneme 参数:

python glmtts_inference.py --data=example_zh --exp_name=_test --use_cache --phoneme

情感表达合成:让声音更有温度

除了音色克隆,这套系统还能迁移情感特征。上传一段带有明显情绪色彩的参考音频(如欢快的节日祝福、低沉的哀悼致辞),生成的语音便会自动继承相应的情感风格。

我们实测了几种典型情感类型的表现:

| 情感 | 声学特征 | 适用场景 |

|---|---|---|

| 开心 | 语速快、音高起伏大、元音拉长 | 节日问候、儿童节目 |

| 悲伤 | 语速慢、音量弱、停顿增多 | 情感故事、公益广告 |

| 愤怒 | 强调重音、节奏紧凑、爆破音增强 | 戏剧对白、警示播报 |

| 平静 | 均匀流畅、无明显波动 | 新闻朗读、知识讲解 |

| 害羞 | 轻柔细语、轻微气音、断续感 | 虚拟偶像、角色扮演 |

有趣的是,系统并未显式标注情感标签,而是通过端到端学习,直接从音频信号中提取并迁移情感特征。这意味着你无需掌握任何语音学知识,只要能找到合适的参考样本,就能“教会”AI表达特定情绪。

一个小技巧是:可以在参考文本中加入表情符号或描述性短语(如“😊 很高兴见到你!”、“大声地说:注意安全!”),有助于强化情感表达。

流式推理:迈向实时交互

对于智能客服、游戏NPC、直播虚拟人等需要低延迟响应的应用,传统的“输入→等待→输出”模式显然不够用。为此,系统提供了流式推理(Streaming Inference)能力。

其核心是 WebSocket 接口,支持逐块返回音频流,Token Rate 固定为 25 tokens/sec。前端接收到数据后即可立即播放,实现接近实时的语音反馈。

示例代码如下:

const ws = new WebSocket('ws://localhost:7860/stream');

ws.onopen = () => {

ws.send(JSON.stringify({

prompt_audio: '/path/to/ref.wav',

input_text: '你好,我是你的语音助手'

}));

};

ws.onmessage = (event) => {

const audioChunk = event.data;

playAudioChunk(audioChunk); // 实时播放音频片段

};

这种设计使得语音合成不再是“黑盒等待”,而是变成可预测、可控制的流式过程,极大提升了用户体验。

性能优化与调试建议

实际部署中,性能往往是决定项目成败的关键因素。根据我们的实测数据,在 RTX 4090 显卡上:

- 短文本(<50字):5–10 秒

- 中等文本(50–150字):15–30 秒

- 长文本(150–300字):30–60 秒

显存占用方面:

- 24kHz 模式约 8–10 GB

- 32kHz 高质量模式约 10–12 GB

并发能力也相当可观:

| 模式 | 最大并发数 | 平均延迟 |

|------|-----------|---------|

| 24kHz + KV Cache | 8 | <1s |

| 32kHz 精准模式 | 4 | ~1.5s |

若遇到生成速度慢的问题,可尝试以下优化策略:

1. 切换至 24kHz 采样率

2. 确保开启 KV Cache

3. 分段处理长文本

4. 检查 GPU 显存是否充足

系统内置了“清理显存”按钮(🧹),可在任务间调用以释放资源,避免内存泄漏累积。

工程实践中的经验总结

经过多个项目的验证,我们总结出一套高效的工作流程:

1. 测试阶段:快速迭代

- 使用10–20字的短句进行快速验证

- 尝试不同类型的参考音频(不同性别、年龄、情绪)

- 固定 seed=42 便于对比效果差异

2. 生产阶段:批量执行

- 提前整理好所有音频路径和文本内容

- 使用 JSONL 批量任务格式统一调度

- 设置固定随机种子,保证输出一致性

3. 质量管控:建立标准

- 建立“黄金参考音频库”,收录效果最好的样本

- 维护专属的 G2P 替换词典,统一专有名词读法

- 定期回听生成结果,持续优化参数配置

4. 特殊场景专项优化

- 方言项目:优先采集本地媒体发布的标准口音素材

- 情感驱动:预先录制同一句话的不同情绪版本作为模板

- 品牌语音:结合 VI 视觉形象,设计统一的语音人格(Voice Persona)

这套 GLM-TTS 系统之所以能在众多语音合成工具中脱颖而出,不仅因为它集成了先进的零样本学习能力,更在于它将复杂的技术封装成了直观易用的接口。从基础合成本地化部署,到支持流式传输的工业级应用,它为开发者提供了一条平滑的成长路径。

未来,随着更多上下文感知、动态情感调节、跨模态联动等功能的加入,这类语音生成系统将不再只是“模仿者”,而是真正具备表达能力的数字生命体。而现在,正是我们开始构建这些声音世界的最佳时机。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)